來源:小蔡AI實驗室

最近DeepSeek王炸不斷,剛剛出了火爆全球的R1大模型,但還有大招沒放!

就在剛剛,準備在多模態大模型正掀起新一輪技術革命浪潮!

DeepSeek新出的Janus-Pro-7B系列作為業界首個理解-生成一體化架構的尖端模型,實現了:

?? 五大顛覆性優勢 ? 視覺問答準確率超越GPT-4V ? 文生圖質量超越DALL·E3、Stable Diffusion 3 ? 單卡即可運行的高效推理 ? 企業級數據隱私安全保障

本教程將帶您完成15分鐘極速部署,R1大模型只要你機器夠,理論上也可以部署哦。

項目地址:https://github.com/deepseek-ai/Janus?tab=readme-ov-file#simple-inference-example-1

模型地址:https://huggingface.co/deepseek-ai/Janus-Pro-7B/discussions

環境要求

-

操作系統: Linux/Windows (推薦 Ubuntu 20.04+)

-

Python: 3.8+

-

CUDA: 11.7+ (需與PyTorch版本匹配)

-

GPU: 顯存 ≥16GB (Janus-Pro-7B需≥24GB)

-

存儲空間: ≥30GB 可用空間

快速部署

1. 克隆代碼庫

git clone https://github.com/deepseek-ai/Janus.gitcd Janus

2. 創建虛擬環境

conda create -n janus python=3.8 -yconda activate janus// 這一步也可以使用pycharm代替

3. 安裝依賴

pip install torch==2.0.1+cu117 --index-url https://download.pytorch.org/whl/cu117pip install -r requirements.txtpip install -e .[gradio] # 安裝Gradio擴展

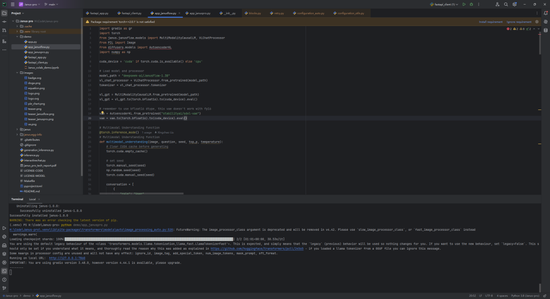

安裝完成后如下:

模型下載

方法一:使用 huggingface-cli 工具

安裝下載工具

pip install huggingface_hub

下載完整模型(推薦)

# 下載7B版本到指定目錄huggingface-cli download deepseek-ai/Janus-Pro-7B \ --local-dir ./models/Janus-Pro-7B \ --resume-download \ --cache-dir ./cache

下載指定文件

# 下載配置文件huggingface-cli download deepseek-ai/Janus-Pro-7B config.json --local-dir ./models# 下載核心模型文件huggingface-cli download deepseek-ai/Janus-Pro-7B pytorch_model.bin --local-dir ./models

下載參數說明

| | | | | --- | --- | --- | | 參數 | 說明 | 示例 | | --local-dir | 指定下載目錄 | --local-dir ./models | | --cache-dir | 設置緩存路徑 | --cache-dir ./cache | | --resume-download | 斷點續傳 | 自動續傳中斷的下載 | | --revision | 指定版本分支 | --revision main |

方法二:代碼自動下載

from transformers import AutoModelForCausalLM# 自動下載到緩存目錄model = AutoModelForCausalLM.from_pretrained(“deepseek-ai/Janus-Pro-7B”)# 指定本地路徑(需先通過huggingface-cli下載)model = AutoModelForCausalLM.from_pretrained(“./models/Janus-Pro-7B”)

使用示例

加載本地模型

model_path = “./models/Janus-Pro-7B” # 指向下載目錄processor = VLChatProcessor.from_pretrained(model_path)model = MultiModalityCausalLM.from_pretrained(model_path).to(“cuda”)

常見問題

下載速度慢

-

使用國內鏡像源:

HF_ENDPOINT=https://hf-mirror.com huggingface-cli download...

-

開啟多線程下載:

huggingface-cli download ... --workers 8

文件校驗失敗

執行完整性校驗:

huggingface-cli download ... --force-redownload

技術說明

-

模型文件結構:

Janus-Pro-7B/├── config.json├── pytorch_model.bin├── tokenizer_config.json└── special_tokens_map.json

-

緩存機制:默認緩存路徑為 ~/.cache/huggingface/hub,可通過 --cache-dir 自定義

手動下載

-

訪問HuggingFace倉庫

-

下載Janus-Pro-7B模型文件

-

解壓到本地目錄 ./models/Janus-Pro-7B

使用示例

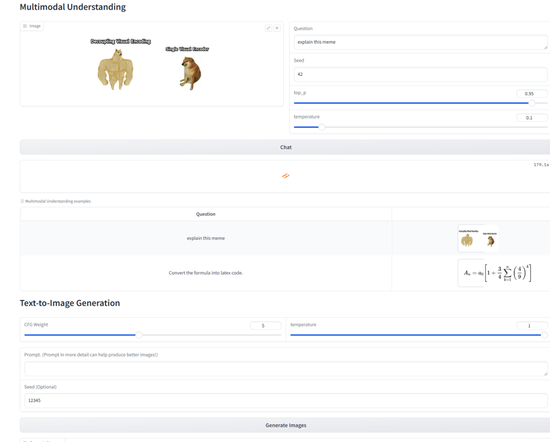

多模態理解

# inference_demo.pyimport torchfrom janus.models import MultiModalityCausalLM, VLChatProcessormodel_path = “./models/Janus-Pro-7B”processor = VLChatProcessor.from_pretrained(model_path)model = MultiModalityCausalLM.from_pretrained(model_path).to(“cuda”)# 構建對話conversation = [ { “role”: “<|User|>”, “content”: “\n描述這張圖片的內容”, “images”: [“sample.jpg”] }, {“role”: “<|Assistant|>”, “content”: “”}]# 處理輸入并生成響應inputs = processor(conversations=conversation)outputs = model.generate(**inputs)print(processor.decode(outputs[0]))

文生圖功能

# generate_image.pyfrom janus.utils import generate_imageprompt = “夕陽下的雪山,山腳下有藍色的湖泊”generate_image( model_path=“./models/Janus-Pro-7B”, prompt=prompt, output_dir=“./outputs”, num_images=4)

Gradio 本地演示

# 啟動文本交互界面python demo/app_text.py --model-path ./models/Janus-Pro-7B# 啟動多模態界面python demo/app_multimodal.py \ --model-path ./models/Janus-Pro-7B \ --port 7860

訪問 http://localhost:7860 使用交互界面

常見問題

顯存不足

-

嘗試減小max_new_tokens參數(默認512)

-

使用低精度模式:model = model.half()

圖像生成質量不佳

-

檢查模型版本(推薦Janus-Pro-7B)

-

調整CFG權重(5-7范圍)

-

增加并行采樣數量(parallel_size=16)

依賴沖突

建議使用官方指定版本:

pip install torch==2.0.1+cu117 pip install transformers==4.33.2

責任編輯:李桐

VIP課程推薦

APP專享直播

熱門推薦

收起

24小時滾動播報最新的財經資訊和視頻,更多粉絲福利掃描二維碼關注(sinafinance)